Wie können wir helfen?

Llama 3 mit Ollama und Open WebUI

Einführung

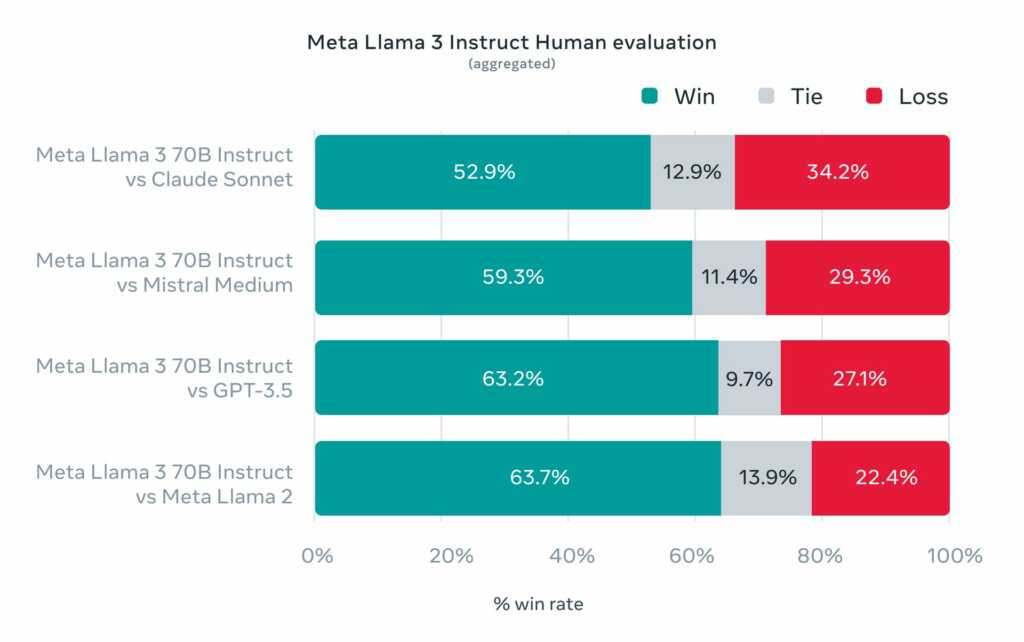

Mit der Veröffentlichung von Llama 3 durch Meta und der Open-Source-Bereitstellung ihrer fortschrittlichen Großsprachmodelle (Large Language Models, LLM) wurde ein bedeutender Fortschritt in der Technologiegemeinschaft erzielt. Llama 3 ist in zwei Varianten erhältlich – mit 8 Milliarden und 70 Milliarden Parametern – und eignet sich für eine Vielzahl von Anwendungen, von Textgenerierung bis hin zur Beantwortung komplexer Fragen.

Ollama: Die Plattform für LLMs

Ollama ist eine kostenlose, Open-Source-Anwendung, die es ermöglicht, große Sprachmodelle wie Llama 3 lokal auf Ihrem Computer zu betreiben. Dies geschieht unter Verwendung von llama.cpp, einer Bibliothek, die das Ausführen von LLMs mit vergleichsweise geringen Hardwareanforderungen ermöglicht.

Installation

Die Installation von Ollama ist unkompliziert und wird für alle drei großen Betriebssysteme unterstützt. Nach der Installation können Sie das Modell einfach über das Terminal starten:

ollama run llama3

Nach dem Download und dem Laden des Modells können Sie direkt im Terminal Dialoge führen.

Nutzung von Open WebUI

Open WebUI ist eine selbst gehostete Benutzeroberfläche, die vollständig in Docker läuft und für die Nutzung mit Ollama oder anderen kompatiblen LLMs wie LiteLLM konfiguriert werden kann.

Installation

Die Installation erfolgt einfach über Docker:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Nach der Installation können Sie auf die Benutzeroberfläche zugreifen, indem Sie http://localhost:3000 in Ihrem Browser öffnen und ein Konto erstellen.

Integration in eigene Projekte

Ollama bietet nicht nur eine eigene API, sondern ist auch kompatibel mit der OpenAI API, was die Integration in bestehende Projekte erleichtert.

API-Nutzung

Hier ist ein einfaches Beispiel, wie Sie Textgenerierung über die API durchführen können:

curl http://localhost:11434/api/generate -d '{

"model": "mistral",

"prompt":"Warum ist der Himmel blau?"

}'

Und so können Sie eine Chat-Interaktion starten:

curl http://localhost:11434/api/chat -d '{

"model": "mistral",

"messages": [

{ "role": "user", "content": "Warum ist der Himmel blau?" }

]

}'

Fazit

Die Verfügbarkeit von Llama 3 und die damit verbundenen Open-Source-Initiativen revolutionieren den Zugang zu hochentwickelten Sprachmodellen. Durch lokale Tools wie Ollama und Open WebUI kann jetzt jeder die immense Leistung dieser Modelle nutzen. Zudem eröffnen die bereitgestellten APIs Entwicklern neue Möglichkeiten, LLMs in ihre Projekte zu integrieren oder bestehende Anwendungen zu verbessern.